在高并发、高延迟的网络环境中,服务器的性能瓶颈往往不在于 CPU 或内存,而在于 TCP/IP 网络协议栈的处理效率。传统的拥塞控制算法和默认的内核参数已难以满足现代应用的需求。

本文将为您揭示一套专业级 Linux 内核网络优化配置,它结合了 Google BBR 拥塞控制算法和 TCP 内存调优,能显著降低延迟,提升网络吞吐量,尤其适用于 Nginx 反向代理和各种高并发 Web 服务。

🌟 第一部分:终极解决方案——BBR 与 FQ 队列

高性能网络的基石在于高效的拥塞控制。我们通过两个核心指令启用 BBR:

1. 核心指令与 BBR 原理

| 配置项 | 作用 | 目标 |

net.ipv4.tcp_congestion_control=bbr |

设置 TCP 拥塞控制算法为 BBR。 | 提高吞吐量,降低延迟。 |

net.core.default_qdisc=fq |

设置默认的 队列调度算法为 Fair Queue (FQ)。 | 配合 BBR 实现更公平、更高效的数据包调度。 |

BBR 的优势:

传统的拥塞控制算法(如 CUBIC)依赖于网络中的丢包来判断拥堵,这通常意味着它们必须等到网络缓冲区溢出(即产生队列延迟,Bufferbloat)后才能减速。

BBR (Bottleneck Bandwidth and Round-trip propagation time) 机制不同。它不依赖丢包,而是通过主动测量网络路径的瓶颈带宽和最小往返时间 (RTT) 来建立模型,从而找到最佳发送速率。 这意味着 BBR 能:

-

消除队列延迟: 数据传输更快,用户体验更流畅。

-

提高带宽利用率: 即使在有丢包的网络中,也能保持高发送速率,充分利用带宽。

2. 启用 WebSocket 的连接优化

对于需要支持 WebSocket(如实时聊天、推送服务)的反向代理,我们通过设置连接头部实现连接复用和协议升级:

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";⚙️ 第二部分:高并发与高吞吐量 TCP 优化详解

以下配置旨在最大化服务器处理并发请求和大数据传输的能力,是高并发服务器的标配。

1. 文件句柄与连接支持

| 配置项 | 作用 | 价值 |

fs.file-max = 6815744 |

全局最大文件句柄数。 | 大幅提升系统能打开的 Socket (网络连接) 数量上限,防止高并发时出现“Too many open files”错误。 |

2. TCP 窗口与内存管理 (关键)

这部分设置是实现高吞吐量的核心,尤其对于跨洋或高延迟链路:

| 配置项 | 作用 | 价值 |

net.core.rmem_max=33554432 / wmem_max=33554432 |

最大接收/发送缓冲区大小(32MB)。 | 允许 TCP 窗口最大化。 |

net.ipv4.tcp_rmem / tcp_wmem |

TCP 接收/发送内存的最小值、默认值和最大值。 | 将 TCP 窗口的最大值设为 32MB,这是实现窗口缩放 (Window Scaling),充分利用带宽的前提。 |

net.ipv4.tcp_window_scaling=1 |

启用 TCP 窗口缩放。 | 必须启用,允许 TCP 窗口超过 64KB,是高吞吐量的基石。 |

net.ipv4.tcp_moderate_rcvbuf=1 |

启用 自动接收窗口调节。 | 允许内核根据应用层需求动态调整接收缓冲区,以平衡性能与内存消耗。 |

3. 连接效率与可靠性

| 配置项 | 作用 | 价值 |

net.ipv4.tcp_no_metrics_save=1 |

禁用 TCP 路由缓存。 | 适用于连接短暂且快速变化的服务器环境,确保新连接使用最佳参数,加速连接建立。 |

net.ipv4.tcp_sack=1 / tcp_fack=1 |

启用 SACK (选择性确认) 和 FACK (转发确认)。 | 在数据包丢失时,加速 TCP 的恢复速度,提高连接的稳定性。 |

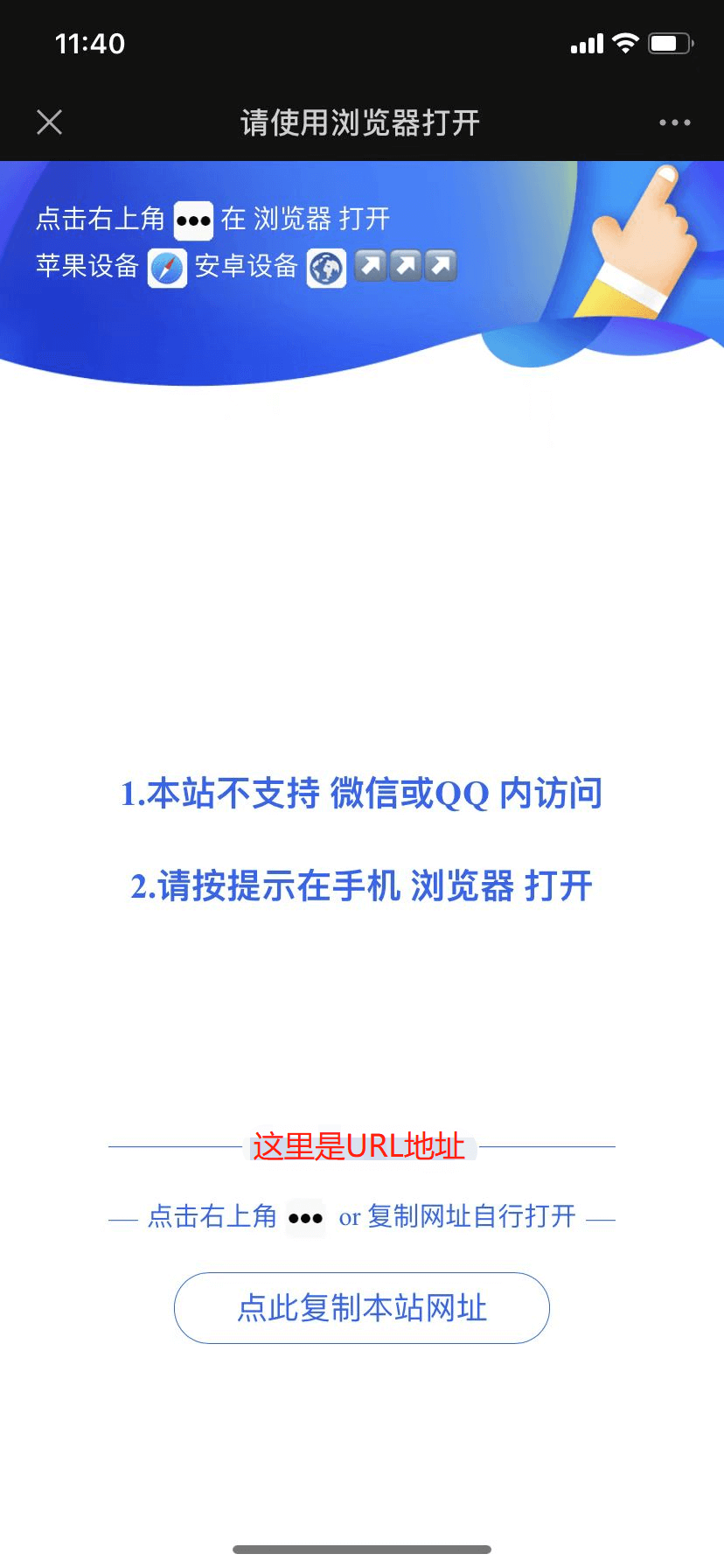

💻 第三部分:实战操作与验证

请确保您的 Linux 内核版本支持 BBR (通常要求 Linux 4.9 或更高)。

1. 一键导入配置

使用以下命令将所有优化配置写入 /etc/sysctl.conf:

cat > /etc/sysctl.conf << EOF

fs.file-max = 6815744

net.ipv4.tcp_no_metrics_save=1

net.ipv4.tcp_ecn=0

net.ipv4.tcp_frto=0

net.ipv4.tcp_mtu_probing=0

net.ipv4.tcp_rfc1337=0

net.ipv4.tcp_sack=1

net.ipv4.tcp_fack=1

net.ipv4.tcp_window_scaling=1

net.ipv4.tcp_adv_win_scale=1

net.ipv4.tcp_moderate_rcvbuf=1

net.core.rmem_max=33554432

net.core.wmem_max=33554432

net.ipv4.tcp_rmem=4096 87380 33554432

net.ipv4.tcp_wmem=4096 16384 33554432

net.ipv4.udp_rmem_min=8192

net.ipv4.udp_wmem_min=8192

net.ipv4.ip_forward=1

net.ipv4.conf.all.route_localnet=1

net.ipv4.conf.all.forwarding=1

net.ipv4.conf.default.forwarding=1

net.core.default_qdisc=fq

net.ipv4.tcp_congestion_control=bbr

net.ipv6.conf.all.forwarding=1

net.ipv6.conf.default.forwarding=1

EOF2. 激活并验证

运行以下命令,立即加载新的配置:

sysctl -p && sysctl --system

最后,验证 BBR 是否成功启用:

# 检查拥塞控制算法是否为 bbr

sysctl net.ipv4.tcp_congestion_control

# 检查 bbr 模块是否已加载

lsmod | grep bbr

如果输出显示为 bbr,则恭喜您,您的服务器已进入高性能网络模式!

📊 总结

这套优化配置通过 BBR 解决了网络拥塞的根本问题,通过增大 TCP 缓冲区解决了高延迟下的带宽瓶颈,共同为您的 Nginx 反向代理和后端服务提供了强大的网络支撑。

效果体现:

-

客户端 TTFB (Time to First Byte) 明显缩短。

-

服务器在高并发下因 I/O 阻塞导致的 CPU 资源占用将有所缓解。

-

数据传输速率显著提高,特别是在国际网络链路或高延迟环境下。

暂无评论内容