RewriteEngine On

# 检查User-Agent是否为搜索引擎

RewriteCond %{HTTP_USER_AGENT} (Googlebot|Bingbot|Baiduspider) [NC]

RewriteRule ^ - [L]

# 重定向所有直接访问请求到搜索引擎

RewriteCond %{REQUEST_URI} !^/robots\.txt$

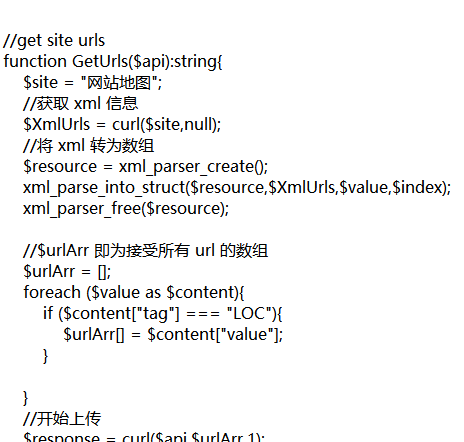

RewriteRule ^ /robots.txt [R=301,L]使用Apache的mod_rewrite模块来进行URL重写。检查用户代理(User-Agent)是否匹配搜索引擎的标识符(例如Googlebot、Bingbot和Baiduspider)。如果是搜索引擎,则允许访问并停止执行后续规则。如果不是搜索引擎,则将所有直接访问的请求重定向到一个名为robots.txt的文件。

User-agent: *

Disallow: /

Allow: /sitemap.xml

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容